Foi em 1965 que Gordon Moore observou que a eletrônica dos semicondutores seguia um processo evolutivo regido por um comportamento muito bem definido.

Esse comportamento, que foi posteriormente descrito em pormenores por Moore num artigo técnico, acabou sendo conhecido por "Lei de Moore" e hoje tem uma importância fundamental na determinação de novos produtos que são lançados continuamente com base nos semicondutores, principalmente os computadores.

Como um "termômetro da indústria de semicondutores, a Lei de Moore trata basicamente do aumento da densidade dos dispositivos semicondutores nos chips influenciando diretamente na estratégia de ação dos fabricantes de uma forma que ficará mais clara com o artigo que estamos levando aos leitores.

O artigo original é de 2002, mas sua importância é grande, pois alguns aspectos da Lei de Moore ainda são válidos e o assunto ainda é centro de muitas discussões quando se fala nas tendências da eletrônica dos próximos anos. Assim, atualizamos o artigo no final, com informações de 2013.

Para tudo existe um limite. As curvas que tratam da evolução de qualquer tipo de tecnologia sempre esbarram com limites teóricos que normalmente significam a transição para novas tecnologias.

Isso fica bem claro o livro "A Infoera" do Prof. João Antonio Zuffo, onde ele analisa as durações das diversas eras tecnológicas e as suas conseqüências, principalmente para quem tem na eletrônica seu campo de atividades.

Para o caso da eletrônica dos semicondutores, base dos computadores, a observação de que havia um limite para a densidade de componentes que poderiam ser integrados numa pastilha de silício, e de que modo isso influenciaria a evolução da eletrônica veio com um artigo publicado numa revista técnica por Gordon Moore em 1965.

Naquela época, os chips não continham mais do que algumas dezenas de componentes, e os computadores ainda eram limitados pelos componentes discretos e baixo grau de integração. Moore afirmava que esse número de componentes, dobrando a cada ano, acabaria por esbarrar num limite que definiria até onde a tecnologia do silício ou a integração poderia ir.

A observação de Moore acabou por se comprovar, não só pelos dez anos seguintes, prazo que Moore previa como de validade para sua lei, mas por muito mais tempo. Conforme mostra o gráfico da figura 2, em que temos a quantidade de componentes por chip para os microprocessadores da Intel. A validade das previsões de Moore fizeram com que ela se tornasse uma Lei, conhecida por Lei de Moore.

Do Transistor ao Circuito Integrado

A nova era da eletrônica certamente começou com a invenção do transistor em 1947.

O "transfer resistor" ou transistor foi criado nos laboratórios da Bell e se baseava no conceito de que era possível controlar o fluxo elétrico num material sólido como o silício. Daí o nome de eletrônica "do estado sólido" para designar a nova tecnologia que substituía (ou pelo menos pretendia) substituir a tecnologia das válvulas onde o fluxo elétrico era controlado no vácuo.

Foi a partir de 1950, entretanto, que ocorreu um significativo progresso nas pesquisas na eletrônica de estado sólido, com a criação de novos processos de projeto e fabricação de dispositivos semicondutores.

Podemos dizer que nessa época a eletrônica dos semicondutores deixou de ser ciência para se tornar muito mais tecnologia de produção.

É interessante observar, nesse ponto, que a cada dia existe um prazo menor entre o momento em que uma descoberta é ciência e se torna tecnologia. Em alguns casos, a descoberta, mesmo eu baseada em ciência pura, já sai diretamente para uso como uma forma de tecnologia.

Antes dessa época os poucos transistores disponíveis comercialmente eram fabricados por processos rudimentares manuais, com um elevado grau de rejeição, bem diferente dos processos em série, em salas limpas, que temos hoje.

O que houve basicamente, a partir dessa época, foi um refinamento das técnicas de produção, que culminou com a invenção do circuito integrado por Jack Kilby em 1958.

O advento do CI significou uma quebra de barreiras tecnológicas com poucas implicações científicas.

Talvez mais importante que a própria invenção CI, em 1950, também foram as inovações no processo de fabricação de dispositivos semicondutores propostas pela Bell e General Electric.

Nessa época foram apresentados os processos de difusão e máscara de óxido e o processo planar, que se tornaram base da produção desde então.

O processo de difusão permitia ao fabricante difundir impurezas ou dopantes, diretamente na superfície do semicondutor, eliminando o trabalhoso processo de colocar e tirar máscaras de material isolante nas diversas camadas sobre o substrato.

Usando processos sofisticados era possível, a partir de então, desenhar padrões intrincados de máscaras para os materiais semicondutores, dopando apenas determinadas áreas. Essas descobertas levaram a um aumento na precisão dos dispositivos que passaram a ser muito mais confiáveis.

Mas, o grande mérito do processo planar estava na possibilidade de se integrar circuitos no mesmo substrato. As conexões elétricas entre os diversos elementos ou circuitos poderiam ser internas ao chip, conforme reconheceu Robert Noyce da Fairchild ao anunciar sua descoberta.

O primeiro transistor planar apareceu em 1959, seguido pelo primeiro circuito integrado planar, em 1961, lançados pela Fairchild.

É claro que os processos evoluíram muito a partir de então possibilitando um aumento constante da densidade de componentes colocados num único chip.

O processo de "fotolitografia" evoluiu possibilitando a integração de componentes cada vez menores.

As Observações de Gordon Moore

Foi em 1965 que, num artigo de uma revista técnica (Electronics), que Gordon Moore publicou o artigo "Cramming more components onto integrated circuits", na ocasião assinando como Diretor do Laboratório de Pesquisa e Desenvolvimento da Fairchild.

No artigo, com menos de 4 páginas, ele levantava a questão se era possível prever o que aconteceria na industria de semicondutores nos 10 anos seguintes, ou seja, até 1975. Ele especulava então, que em torno de 1975 seria possível concentrar num único chip algo em torno de 65 000 componentes, ocupando uma área de 1/4 de polegada quadrada. Na ocasião ele afirmava que:

"A complexidade para um mínimo custo de componentes tem crescido numa taxa que se aproxima do fator dois por ano. Certamente, a curto prazo, espera-se que essa taxa continue, senão aumente. A longo prazo, a taxa de crescimento pode um pouco mais incerta, apesar de que não há razão para acreditar que ela permaneça constante por pelo menos 10 anos." (Moore, 1965)

Dez anos mais tarde, Moore reexaminava a taxa de crescimento anual da densidade de componentes. Essa alteração deveu-se ao aparecimento de novas tecnologias como os dispositivos MOS e as memórias CCDs (charge-coupled devices).

No documento ele mostrava tendência em aceitar o crescimento exponencial por diversos motivos, dentre eles:

a) O tamanho das pastilhas estava crescendo numa taxa exponencial. Os chips estavam se tornando cada vez maiores.

b) As dimensões dos componentes integrados estavam se tornando cada vez menores numa taxa que se aproximava da exponencial.

c) Melhoria das tecnologias internas usadas na integração, como aumento da isolação, advento de novas tecnologias como MOS, etc.

Com essa revisão, segundo Moore, a taxa de aumento da densidade de componentes deveria ser tal que dobraria a cada 18 meses ou quadruplicaria a cada 3 anos.

Escrita na forma matemática ela fica:

(Circuitos por Chip) = 2(ano-1975)/1,5

Em 1995, Moore fez uma comparação de suas previsões com duas categorias de dispositivos: memórias DRAM e Microprocessadores. Os dois dispositivos tiveram um crescimento bem próximo da curva prevista por Moore, com as DRAMs alcançando uma leve vantagem na quantidade de dispositivos integrados (densidade) no período que vai de 1970.

As observações tinham se baseado na evolução dos dispositivos semicondutores a partir de 1950 na seqüência que levou a média escala de integração (MSI) dos anos 1960, para a larga escala de integração (LSI), dos anos 1970, e escala muito alta de integração (VLSI) dos anos 1980, e a Escala Ultra-Alta de Integração (ULSI) dos anos 1990. Os chips com milhões de componentes integrados já são comuns e já fala em chips de gigabits e até terabits para as próximas décadas.

Barômetro Tecnológico

Talvez a mais importante das implicações da Lei de Moore é o fato de que ela funciona como um verdadeiro barômetro tecnológico. Algumas publicações referem-se à Lei de Moore como "benchmark", padrão ou mesmo regra, mas definitivamente, podemos dizer que se trata de uma forma de se "medir" a tendência de inovações de desenvolvimento da indústria de semicondutores e, por tabela, dos computadores.

Um alto executivo de empresa fabricante de semicondutores chegou a afirmar que a Lei de Moore: "é importante porque é a única regra estável que temos hoje para saber que os concorrentes vão fazer daqui a 18 meses e também aquilo que também temos de fazer para não sucumbir à concorrência".

Se levarmos em conta que o custo tanto é medido pelo tamanho como pela complexidade do chip, com a redução do tamanho temos a redução do custo e como resultado final, os chips vão se tornando cada vez mais acessíveis.

Hoje, temos uma infinidade de aplicativos em que eles são usados, indo desde brinquedos, e aparelhos de uso doméstico, até equipamento médico, satélites e armas. Isso significa que a Lei de Moore também tem implicações sociais e econômicas que devem ser levadas em conta.

Mas, além de possibilitar uma previsão do que vai acontecer no futuro, a Lei de Moore também serve como uma espécie de alavanca que propulsiona os novos desenvolvimentos, pois qualquer empresa sabe que, se não seguir suas tendências, ela será deixada para trás.

Acompanhar a Lei de Moore, para as empresas desenvolvedoras e fabricantes de semicondutores, não é simplesmente uma curiosidade, para saber o que se deve fazer e o que os outros estão fazendo; é uma questão absoluta de sobrevivência.

É importante notar que, além das variáveis físicas, existem as varáveis não físicas que podem estar envolvidas na validade da Lei de Moore.

Veja que, a Lei de Moore, em si não é somente baseada nas propriedades físicas e químicas dos semicondutores assim como nos seus processos de produção, mas também em fatores não técnicos. Podemos colocar no rol desses fatores as influências dos sistemas sociais e econômicos, como já afirmamos.

Podemos tomar como exemplo o que ocorre com os chips dos computadores pessoais, como por exemplo, os microprocessadores, sistema de software e memória.

Enquanto os microprocessadores, a partir do 8086/8088 até o Pentium IV se tornaram mais rápidos, mais poderosos e proporcionalmente menos caros escapando levemente da previsão pela Lei de Moore, as memórias DRAM e suas formas derivadas, seguiram um padrão mais regular.

Na figura 7 temos uma curva que mostra a evolução das características das DRAMs, quando comparadas com uma curva que mostra como deveria ser o crescimento se a sua capacidade dobrasse a cada 21 meses (valor inicialmente previsto para esse tipo de componente).

Na figura 8, por outro lado, temos a evolução do número de transistores nos chips.

Entretanto, existe um terceiro elemento do custo de um PC, que é o software, e que revelou um comportamento não técnico para a Lei de Moore.

A Importância dos Computadores

Quando falamos na Lei de Moore para os computadores devemos incluir o software como elemento que pode influir na sua aplicação.

Hoje em dia a maior parte do consumo de chips é representado pela indústria de computadores. Em segundo lugar vem a indústria de telecomunicações e depois todo o restante.

Duas leis paralelas, que levam um certo tom humorístico, relacionam o desenvolvimento dos chips com o desenvolvimento do software e são denominadas "Leis de Parkinson".

Elas dizem que "O software expande para preencher a memória disponível, e o Software está se tornando mais lento na proporção direta que o hardware se torna mais rápido".

Na verdade, alguns chegam até a dizer que todas a vezes que se aumenta a quantidade de transistores disponíveis no chip de um micrprocessador, Bill Gates "arranja" um meio para seus softwares desperdiçá-los.

Outros vão além de definem a "Lei de Gates (Bill)" que diz que a "velocidade dos softwares se reduz à metade a cada 18 meses".

Até Quando a Lei de Moore Será Válida?

Desde 1995 artigos diversos foram publicados, colocando em discussão se a Lei de Moore ainda valeria por muito tempo. Mas nenhum chega a uma conclusão definitiva sobre seu fim.

Assim, no dia 10 de julho de 2002, Gordon Moore recebeu do Governo dos Estados Unidos, a medalha Freedon. O presidente Bush comandou a cerimônia.

Naquela ocasião Moore afirmou que a velocidade com que a densidade dos componentes num chip dobra iria diminuir um pouco nos próximos anos, principalmente dadas as próprias limitações da física.

A capacidade que os projetistas de semicondutores têm para integrar cada vez mais componentes num chip está limitada pelas leis da física que, começam a ter um efeito maior a cada dia.

Pelos processos tradicionais de desenvolvimento de chips esperava-se que os projetistas teriam problemas quando as dimensões encolhessem para 30 nanômetros.

No entanto, como falamos no início, sempre pode haver a interferência de novas descobertas ou de novas tecnologias que mudam as previsões. No caso, é a nanotecnologia que está entrando em cena.

Moore lembra-se de ter dito que o limite para o encolhimento dos chips seria um mícron, dados os problemas da litografia óptica, isso em 1990. No entanto, com a nanotecnologia isso já não é válido e o próprio Moore já disse que espera ver dispositivos com diversos bilhões de transistores integrados.

Uma descoberta importante que pode aumentar a vida da Lei de Moore, é a que se relaciona com o uso da luz ultravioleta extrema ou Extreme Ultraviolet (EUV) aplicada à litografia.

As dimensões mínimas de um detalhe, que pode ter sua imagem gravada num chip de silício dependem também do comprimento de onda usado no processo. Se o objeto for menor que o comprimento de onda, a onda passa através dele sem deixar sombra.

Assim, não se pode gravar num chip um transistor ou um detalhe de um componente cujas dimensões sejam menores do que o comprimento da onda da luz usada no processo.

O limite atual estava justamente na capacidade dos equipamentos usarem radiação de comprimento de onda cada vez mais curto como, por exemplo, o ultravioleta.

No entanto, com o progresso da tecnologia de semicondutores, até mesmo o ultravioleta está se tornando insuficiente para dar bons resultados com os detalhes menores que se pretendia gravar.

Assim, o uso da tecnologia EUV (Extreme Ultraviolet) estende a validade da Lei de Moore, com a possibilidade de criação de dispositivos que estão além dos limites que o próprio Moore imaginava quando estabeleceu sua lei.

Na figura 10 mostramos o processo de gravação de um chip usando a tecnologia do EUV.

Conclusão

A Lei de Moore, apesar de contestações, da colocação em jogo de seu tempo de validade, tem permanecido firme nas últimas décadas, apesar da aproximação teórica dos limites de integração dados pelas leis da física.

A criação de novas tecnologias, vencendo barreiras colocadas pelas limitações físicas tem mantido a sua validade e importância.

A principal importância da Lei de Moore se mantém, já que se trata de um dos poucos parâmetros confiáveis e estáveis que a industria de semicondutores pode usar nas suas previsões.

Como afirmamos, a Lei de Moore é o barômetro que indica o que a indústria deve fazer nos anos seguintes e assim direcionar a criação dos seus produtos com boa chance de que eles não cheguem ao mercado defasados ou ainda utilizando tecnologias que já estejam superadas na época do lançamento.

A Lei de Moore ainda vale. Por quanto tempo? Não sabemos, pois, nem mesmo Gordon Moore acreditava, de início, que sua Lei pudesse durar tanto...

Há alguns anos a Lei de Moore começou a ser ameaçada pelo que parecia ser o limite para a miniaturização dos componentes que poderiam ser integrados num chip.

A própria litografia por ultravioleta (UV) estava chegando a um ponto em que componentes menores e, portanto em maior quantidade não poderiam mais ser gravados no silício.

Da mesma forma o próprio tempo de trânsito dos portadores de carga nos materiais semicondutores começava a impor limites para o tamanho que um chip teria sem comprometer seu desempenho.

No entanto, em 2011 algumas novas tecnologias apareceram dando mais um certo tempo de fôlego para a Lei de Moore.

Considerando que um componente como um transistor tem uma estrutura bidimensional no chip os limites para sua integração estavam basicamente determinados pelo que se poderia fazer nestas dimensões.

Entretanto, uma parceria da IBM com a 3M possibilitou a criação de novos adesivos que seriam utilizados na construção de chips tridimensionais. Assim, em lugar de espalharmos os transistores por uma superfície, seria possível espalhar componentes por um volume.

A ideia inicial é de que 100 chips separados formariam camadas que resultariam num chip único com 1000 vezes a velocidade do computador mais rápido que temos e uma quantidade 100 vezes maior de transistores.

O gráfico da figura 11 mostra a situação da Lei de Moore em 2011 com a possibilidade dela seguir a curva prevista aproximada por alguns anos ainda.

Algumas outras leis apareceram nos últimos anos tentando fazer previsões sobre o futuro dos semicondutores, mas a que mais está tomando corpo é a que leva em consideração a eficiência de um microcontrolador ou microprocessador.

De fato, para as aplicações modernas, muito mais do que a quantidade de transistores de um chip ou sua velocidade de operação, é o consumo de energia. A eficiência com que um conjunto muito grande de componentes aproveita a energia é hoje talvez um fator fundamental para a tecnologia.

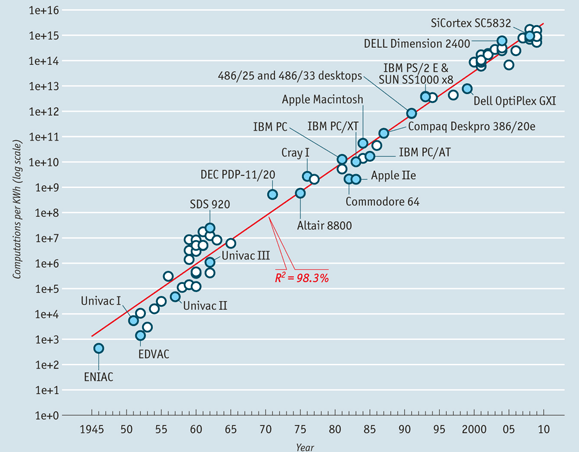

No gráfico da figura 12 temos então a evolução da eficiência dos chips dos computadores, numa curva bastante semelhante àquela dada pela Lei de Moore.

Algumas fontes publicaram em 2005 estudos que revelavam que a Lei de Moore valeria até 2015 a 2020. No entanto, uma atualização do International Roadmap for Semiconductors revelou que a curva de validade desta lei mudou um pouco, e as densidades dos transistores nos chips devem dobrar a cada 3 anos.