Os sons gravados na forma digital (CDs) já não são novidade e uma grande quantidade de pessoas desfruta da sua excelente qualidade. A televisão, que evoluiu rapidamente com a melhoria da qualidade do som (estéreo e SAP), e mesmo da imagem com novos formatos (16/9) e alta definição tende também a passar para uma nova era com a transmissão digital. A quantidade de dados que devem ser digitalizados numa imagem de TV para transmissão é enorme, exigindo técnicas especiais de compressão e transmissão que tornam o sistema muito mais complexo que a TV comum e demanda um novo preparo dos profissionais da área. Com a entrada do sistema no Brasil inicialmente nos sistemas via satélite, os leitores devem estar preparados para entender e resolver problemas que envolvem esta nova modalidade de TV.

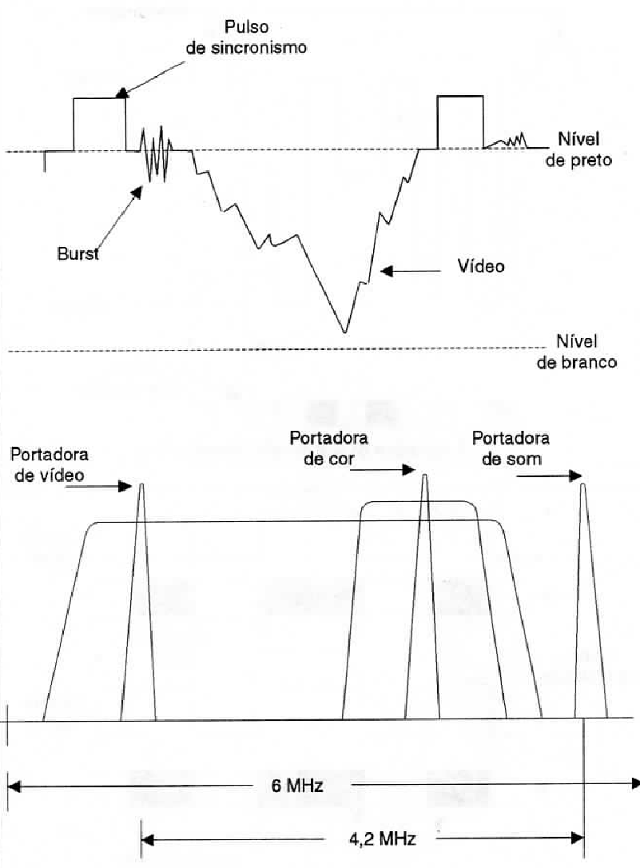

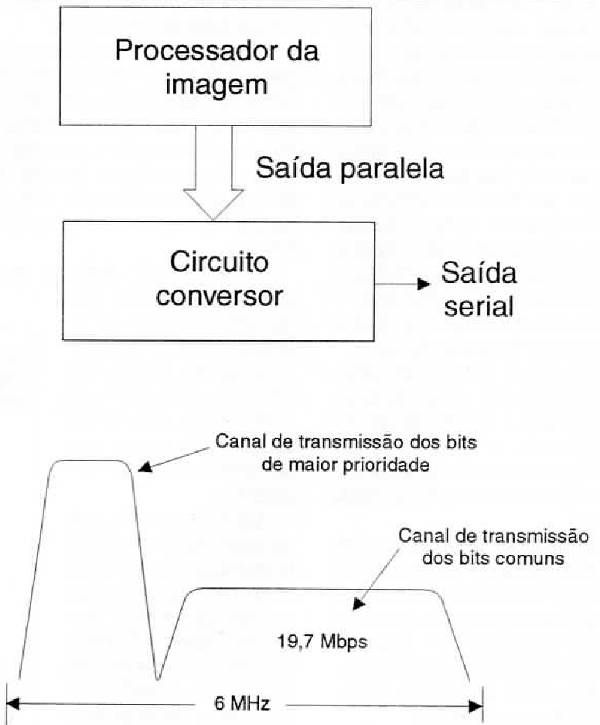

A imagem que obtemos em nossos televisores no sistema convencional ainda é totalmente transmitida na forma analógica. Tanto o sinal de luminosidade (luminância) como o de cor (crominância) são transmitidos na forma de variações de intensidade do sinal, ou seja, a partir de um sistema modulado em amplitude, conforme mostra a figura 1.

Isso significa que cada ponto da imagem a ser reproduzida depende apenas do valor instantâneo do sinal de luminância e de crominância.

Para se obter uma boa imagem, como as que temos hoje normalmente em nossos televisores, as variações rápidas dos sinais devem ser transmitidas e respondidas pelos circuitos dos televisores. Assim, para que a imagem tenha a qualidade esperada. o sinal deve ocupar uma faixa de 4.5 MHz, que todos os técnicos reconhecem de seus estudos teóricos.

Os 4,5 MHz ocupados pelo sinal de vídeo, em princípio podem transmitir todos os pontos de uma imagem de TV, lembrando que cada quadro tem dois campos e certo número de pontos e que temos 30 quadros reproduzidos em dada segundo.

O fato de nossos olhos serem menos sensíveis às cores do que à intensidade luminosa permite que nos pequenos detalhes de uma imagem a cor não seja importante, o que leva à possibilidade de se ter uma largura de faixa para o sinal de cor bem menor do que a largura de faixa para o sinal de luminância.

Na prática, além de não termos nos nossos receptores o número máximo de pontos de definição que o sistema oferece, precisamos conviver com outras deficiências como por exemplo a baixa imunidade a interferências, ruídos e aos fantasmas provocados pelas reflexões.

PONTOS DE IMAGEM

Conforme o leitor percebeu, é o número de pontos que a imagem reproduz que determina a sua qualidade. Uma imagem com mais pontos tem mais pormenores e, portanto, é mais nítida.

Os pontos de imagens são denominados “pixels" uma palavra obtida da união de Picture + Element ou elemento de imagem, do inglês.

Assim, a principal especificação da qualidade de uma imagem, como por exemplo a transmitida por um sinal ou apresentada na tela por um televisor, é o número de pixels que ele pode apresentar na tela. Quanto maior for esse número, melhor é a sua qualidade.

A IMAGEM ANALÓGICA

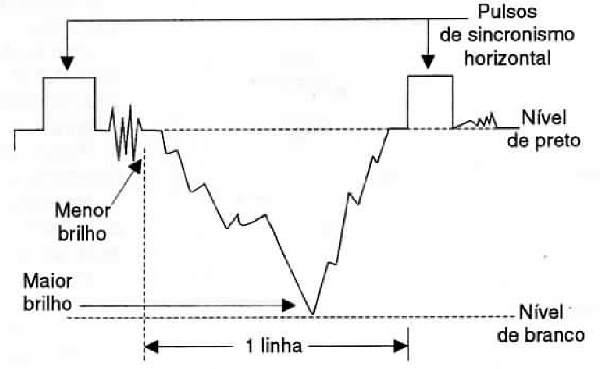

No sistema de TV em cores convencional, por exemplo no PAL, temos sinais de Iuminância e de crominância que indicam ao receptor em cada instante qual deve ser o brilho (Iuminância) e a cor (crominância) de um determinado pixel, conforme mostra a figura 2.

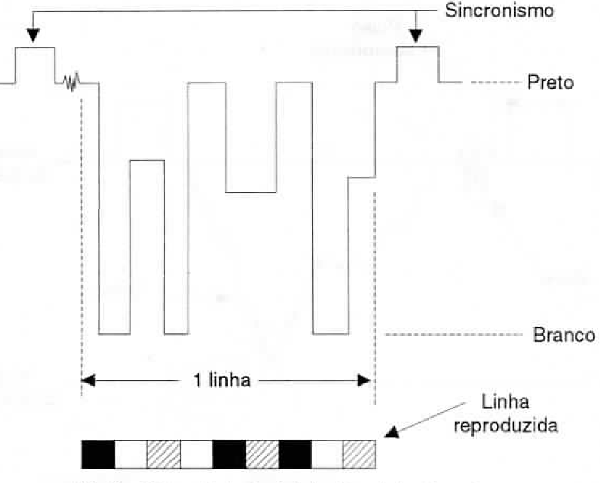

Para o brilho, a intensidade do sinal é que determina se ele vai ser mais claro ou mais escuro. Assim, no tempo de uma linha, conforme mostra a figura 3, as variações da intensidade do sinal vão fixar o brilho de cada ponto que deve ser reproduzido.

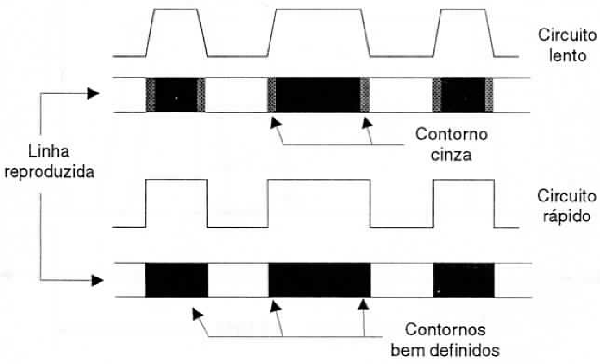

O leitor pode perceber claramente que quanto maior for a capacidade do circuito de responder às variações rápidas da intensidade desse sinal, maior será sua capacidade de fazer as transições de brilho e, portanto, definir claramente os pontos da imagem.

Conforme também explicamos no início, para a Iuminância usamos uma faixa de frequências mais larga porque os olhos são mais sensíveis a esta característica do que à cor.

Fica evidente que um circuito mais rápido na resposta pode definir contornos mais precisos de uma imagem, ou seja, variações entre os claros e escuros, conforme mostra a figura 4.

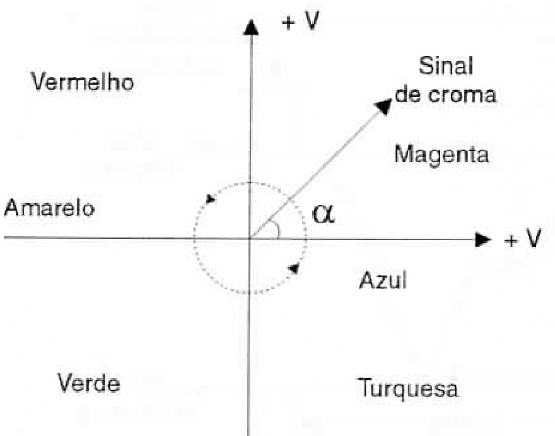

Para a cor de cada ponto temos o sinal de croma que transporta a informação de uma forma um pouco diferente.

No tempo de uma linha, este sinal tem fase e intensidade variando conforme a cor de cada ponto de imagem que dever reproduzido, conforme a figura 5.

Como as cores básicas a partir das quais o cinescópio pode reproduzir todas as outras são três e um sinal deste tipo só pode transmitir a informação sobre duas, um artifício interessante, bem conhecido dos que estudaram TV em cores, é usado.

A fase do sinal de croma determina, pela decomposição vetorial, a intensidade dos sinais que correspondem às cores azul e vermelho (R e B e que são os sinais B-Y e R-Y).

Como a soma das intensidades dos três sinais deve ser 100%, por simples complementação os circuitos podem obter a intensidade do sinal G.

Ora, partindo desses sinais que são modulados em amplitude e em fase, para a transmissão da imagem no sistema analógico, como obter uma imagem e transmitir na forma digital?

OS MONITORES DE VIDEO

Os monitores de vídeo atuais, que usamos em nossos computadores dão uma ideia de como podem ser digitalizadas e transmitidas imagens de TV.

Nos primeiros tipos de monitores, o princípio de funcionamento era muito semelhante ao da TV atual.

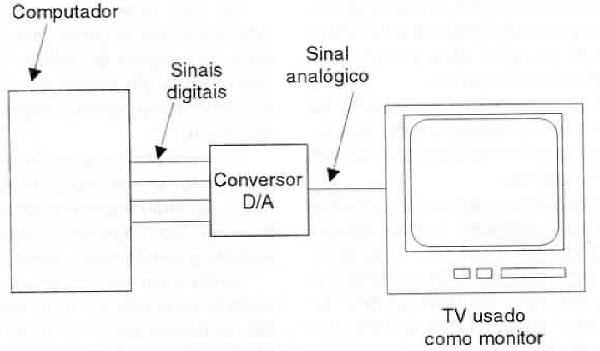

Uma imagem digital produzida pelos circuitos era levada para a forma analógica de modo a se poder usar um televisor comum para sua visualização ou um monitor cujo princípio de funcionamento não fosse muito diferente de um televisor comum, conforme mostra a figura 6.

No entanto, um monitor de vídeo pode apresentar imagens muito melhores que um televisor comum se puderem acompanhar o desempenho dos modernos circuitos de computadores. Para isso, entretanto, ele deve funcionar de uma forma diferente.

Essa forma diferente é que serve de base para o televisor digital.

Se bem que o sistema de varredura e de produção de quadros de um monitor seja o mesmo de um televisor comum, a imagem a ser reproduzida pode ser totalmente definida por pontos de imagem ou pixels individuais.

Cada pixel pode ter suas características determinadas de uma forma digital ou por um valor numérico. (Os franceses preferem chamar este tipo de TV de "numérica" em lugar de digital, no sentido de que as características dos pixels podem ser definidas por valores numéricos).

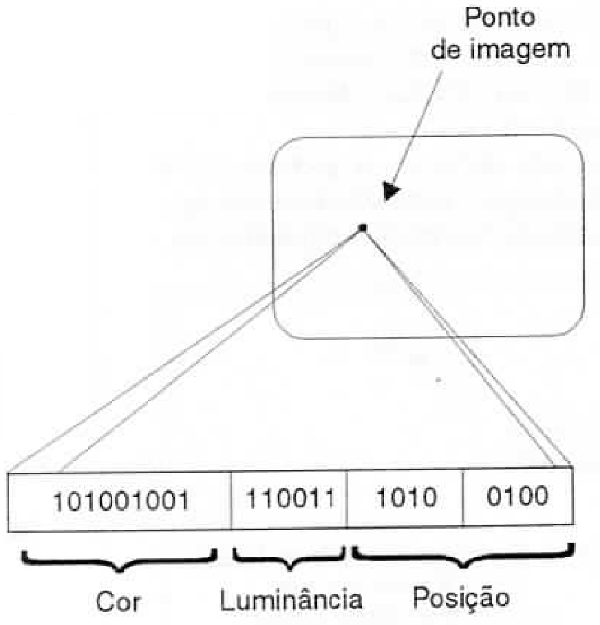

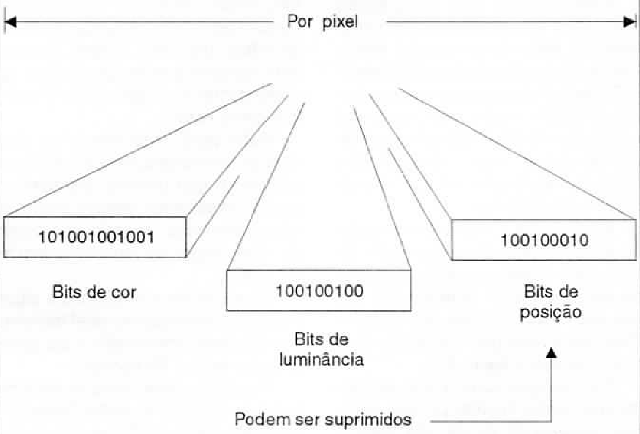

Na forma mais simples podemos fixar uma certa quantidade de bits para a cor e uma certa quantidade de bits para a intensidade, e uma certa quantidade de bits para dizer em que ponto da tela deve ser reproduzido aquele ponto, conforme mostra a figura 7.

Neste caso, usando 8 bits para a cor e 8 bits para a luminosidade, podemos ter uma “palheta" de 256 cores para o sistema o que pode ser considerado bastante bom.

Assim, para transmitir uma imagem desta forma “digitalizada" precisamos ter três grupos de bytes, um indicando a resolução (luminosidade do ponto de imagem), um indicando seu atributo ou a cor que ele deve ter, e um para indicar em que ponto da tela deve aparecer cada ponto da imagem.

É interessante observar que na terminologia usada para os computadores, as intensidades são consideradas cores. Assim, com 8 bits de cor e 8 bits de intensidade não temos apenas 256 cores, mas sim 256 x 256 = 65 536 cores!

Uma forma diferente de tratar as cores consiste em usar um certo número de bits para cada cor básica. Assim, num sistema como o TARGA, são utilizados 5 bits para o vermelho, 5 para o azul e 6 para o verde (segundo pesquisas o olho humano tem maior sensibilidade ao verde), de modo que as correntes dos canhões correspondentes do tubo de raios catódicos são controladas separadamente a partir da placa adaptadora.

Com 16 bits de resolução podem ser reproduzidas mais de 16 milhões de cores diferentes!

Mas, passando isso ao televisor, temos problemas a considerar que não parecem no caso de um monitor de vídeo. Como tratar a imagem?

PROBLEMAS PARA O CASO DA TV DIGITAL

Num computador existe uma certa facilidade de transmissão da fonte de sinal ao sistema que deve reproduzir. O computador já gera as imagens na forma digital, armazenando-as numa memória (memória de vídeo) a partir da qual elas podem ser transferidas ao monitor.

Essa transmissão pode ser feita até na forma paralela, o que não exige uma resposta de frequência muito alta do sistema.

Lembramos que para um sistema de deva reproduzir muitas linhas, muitos pontos e até com mais quadros por segundo como ocorre em computadores, as velocidades de resposta dos circuitos devem ser muito altas.

Assim, para o VGA de 350 linhas o “canal de vídeo" deve ter pelo menos 28 MHz de largura, pois essa é a frequência do clock que comanda a transmissão dos pixels. Existem sistemas em que essa largura vai além dos 44 MHz.

Para o caso da TV, isso significa que temos uma série de problemas adicionais a considerar na transmissão de uma imagem digitalizada.

O primeiro ponto consiste na necessidade de atribuirmos a cada ponto da imagem, bytes que representem sua cor e sua intensidade (conforme veremos, a posição pode até ser suprimida). O número de bits que cada byte vai ter vai determinar a qualidade desta imagem, como no caso dos monitores de vídeo.

No entanto, quanto maior for o número de bits atribuídos a cada ponto, mais informações por segundo temos de transmitir e isso significa a necessidade de um canal de largura maior.

O sistema de TV digital que deve ser adotado em nosso pais é o MPEGZ ou MPEG++ (Moving Picture Experts Group).

Neste sistema, a câmara varre uma imagem produzindo sinais que consistem nos pontos digitalizados.

Se este sinal fosse serializado para transmissão direta seria necessária uma banda de vídeo extremamente larga, da ordem de dezenas de mega-hertz ou mesmo centenas de mega-hertz.

Isso impediria que os processos convencionais de transmissão por sinais de rádio fossem empregados, pois um canal “encheria” facilmente se toda a banda destinada a isso.

Basta levar em conta que se tivermos uma imagem com 800 pontos de resolução por linha e 600 Iinhas como no VGA e 16 milhões de cores definidas por 24 bits, a memória para cada quadro é de 1 440 000 bits.

Como em cada segundo temos 30 quadros, passamos dos 40 MHz de frequência mínima necessária para sua transmissão.

Num sistema de TV de alta definição, a faixa passante de um circuito para uma transmissão direta seria ainda mais larga.

Levamos com conta nesta transmissão que, diferentemente de um monitor de vídeo ou de um sistema a curta distância em que podemos ter uma transmissão totalmente paralela ou parcialmente paralela, os dados referentes a cada ponto da imagem devem ser transmitidos “serialmente”.

Evidentemente, um canal com dezenas de mega-hertz de largura não cabe nas faixas atuais de UHF e VHF o que significa que este sistema, em princípio não poderia ser adotado desta forma para a TV convencional.

Conforme veremos, entretanto, “artifícios" permitem estreitar a faixa de onda necessária à transmissão dos sinais a ponto de atualmente já se pensar na possibilidade de utilizar meios "terrestres" para sua transmissão como a fibra óptica, cabos e mesmo SHF (se não UHF e VHF num futuro próximo).

No entanto, as faixas de micro-ondas usadas pelos satélites admitem canais com larguras bem maiores, o que significa que em princípio a TV digital pode ser usada nesta modalidade e isso já está sendo feito.

Existem diversas maneiras de obtermos um estreitamento da faixa necessária à transmissão de tantos bits de informação como os que seriam necessários para uma TV digital.

COMPRESSÃO DA IMAGEM

Logo que os sinais digitais correspondentes a uma imagem, numa taxa de amostragem de centenas de megabytes por segundo são obtidos, estes sinais passam por um computador que tem por finalidade comprimi-Ios.

Para se obter uma compressão dos dados que correspondem a uma imagem, além de processos semelhantes aos usados quando desejamos comprimir arquivos num computador, temos outros que levam em conta, não só propriedades especificas de nossa visão como de uma cena em movimento do tipo encontrado numa televisão.

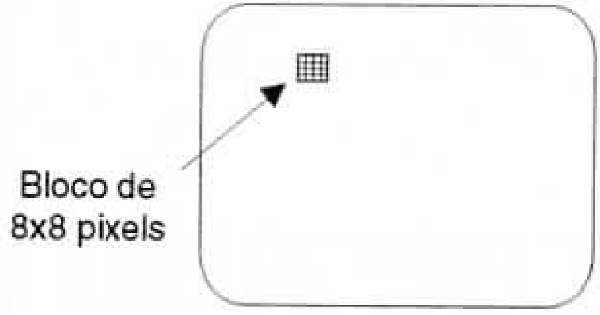

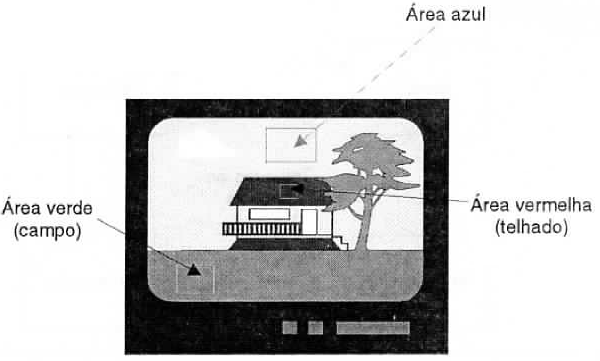

Assim, uma primeira possibilidade consiste em indicar por meio de instruções simples quando uma área da cena tem uma determinada cor em lugar de transmitir as informações desta área ponto a ponto, conforme mostra a figura 10.

Por exemplo, uma região vermelha que tenha 10 000 pontos, cada qual precisando de 24 bits para a transmissão, ocuparia 240 000 bits do sinal. Se em lugar disso, definirmos a região por meio de uma fórmula simples (por exemplo um quadrado) e simplesmente dissermos que este quadrado deve ser vermelho, usaremos menos de 1 000 bits.

Da mesma forma, se temos uma linha reta numa cena, não precisamos indicar ponto a ponto esta linha. Definimos suas extremidades, espessura e cor e com isso ganhamos muitos bits.

As características de uma imagem televisionada diante do olho humano permitem aplicar processos adicionais de compressão que reduzem ainda mais o número de bits necessário à transmissão de uma imagem.

Numa cena com fundo parado (por exemplo com a câmara fixa) o fundo não precisa ser retransmitido ponto a ponto em cada quadro. Basta indicar transmitir a parte da imagem da cena que muda e indicar ao computador do receptor que o resto fica como está!

Outro ponto importante é a graduação de tons que pode existir numa imagem e que permite que apenas os pontos extremos desta graduação sejam enviados, ficando por conta do computador do receptor completar o sinal.

Com tudo isso chegamos a algumas características do sinal transmitido bastante interessantes, se comparadas com a TV comum.

A primeira delas está no fato de que a quantidade de dados transmitidos pode variar conforme seja transmitida uma cena parada ou uma cena de muito movimento. Em outras palavras. & largura de faixa no sistema digital pode mudar em função do programa. Um jogo de futebol com cenas de transição muito rápidas exige a transmissão de mais bits do que uma novela ou um telejornal com a figura do apresentador num cenário totalmente parado.

A segunda característica importante está na não necessidade de sincronismo ou do endereçamento dos pontos de imagem.

O endereçamento dos pontos pode ser feito no início de cada quadro, e o próprio receptor conta os pontos recebidos de modo a posicioná-los na tela e assim obter a imagem. Mais que isso, o receptor pode identificar o formato do sinal e assim reproduzir imagens 3 x 4 como na comum, 16 x 9 ou HDTV conforme o receptor e o programa com uma compatibilização totalmente automática. Veremos isso com mais detalhes mais adiante.

Com todas estas técnicas, pode-se reduzir muito o número de bits a ser transmitido com um consequente estreitamento da banda ocupada pelo sinal. No entanto, além do próprio tratamento dos sinais digitais, temos ainda as técnicas usadas na transmissão, aproveitando-se a experiência dos modems comuns usados na transmissão de sinais via linha telefônica.

AS TÉCNICAS DE MODEM

As coisas podem estar ficando mais complicadas aparentemente, se pensarmos que precisamos transmitir milhões de bits por segundo e o canal de vídeo convencional tem sua largura bem limitada.

O leitor pode ainda questionar que tudo isso é apenas para a informação básica de vídeo. Onde fica o sincronismo e o som?

Se bem que o som não precise ocupar um canal tão largo, o problema do sincronismo pode aparentemente complicar as coisas.

De fato, além da intensidade (brilho) e cor (crominância) de cada ponto, precisamos saber em que local da tela ele deve aparecer, ou seja, precisamos transmitir suas coordenadas. A forma mais imediata seria transmitir mais duas séries de bits que informariam ao receptor em que linha e em que ponto da linha ele ficaria, conforme mostra a figura 11.

No entanto, para 400 linhas de resolução com 600 pontos por linha, como usado no VGA, teríamos de usar pelo menos mais 8 bits para as linhas e 9 bits para a posição na linha. Multiplicando pelo número de pontos por quadro e pelo número de quadros, o leitor pode facilmente entender o que isso significa em termos de mega-hertz a mais para o canal de vídeo.

Mas, não é preciso informar ao receptor a posição de cada ponto de imagem separadamente, conforme já explicamos no item anterior.

Esta informação pode ser obtida no receptor de modo automático de duas formas: em função do instante em que o ponto deve ser reproduzido, como nos televisores comuns, ou a partir de um byte de referência que acionaria um “contador” que determinaria a posição na tela em que o ponto deve ser reproduzido. Essa informação de referência também indicaria o comprimento da linha e o número de linhas, fixando assim o formato da imagem.

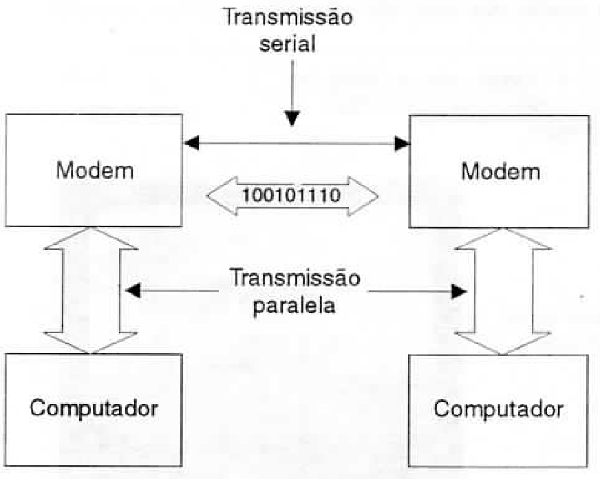

Também podemos ter uma redução razoável na largura de faixa ocupada na transmissão de um canal digital de TV se usarmos as mesmas técnicas empregadas nos modems comuns.

Modem é a abreviação de MOduIador/DEModulador e consiste num circuito que transforma em informação serial uma informação digital na forma paralela e vice-versa, de modo que ela possa ser transmitida por um único fio, por exemplo uma linha telefônica, conforme mostra a figura 12.

O tipo mais comum de Modem é o FSK (Frequency Shift Keying) em que temos dois tons que representam os bits 0 e 1. Os dois tons mudam de frequência rapidamente conforme a sequência de bits que deve ser transmitida.

Ora, uma linha telefônica foi projetada para transmitir frequências corresponde à faixa “inteligível” da voz humana, e que é uma faixa disponível muito estreita. Além disso, para reconhecer cada tom, devem ser transmitidos pelo menos 3 ciclos completos desse tom, 0 que significa que a “faixa útil” desse sistema está muito limitada. Na prática, os sistemas FSK não iam além dos 300 bits por segundo.

Levando em conta que cada transição do sinal transmitido corresponde a um Baud, em princípio, neste sistema, o número de bauds por segundo se iguala ao número de bits.

Sistemas melhores foram sendo criados até se chegar ao valor mais próximo de 3 000 Hz da faixa passante das linhas que foi 2 400 bauds.

O limite de 3 000 bauds poderia ser considerado a “fronteira final" se não fosse possível usar técnicas alternativas.

Na verdade, o limite teórico para a transmissão de dados por uma linha telefônica e dado pelo Limite de Shannon, que leva em conta & largura de faixa e o nível de ruído do canal e que no caso é de 19 200 bits por segundo. Na prática este limite não é alcançado pelos métodos comuns, mas métodos especiais conseguem ultrapassá-Io, conforme veremos.

De fato, cada transição do sinal transmitido não precisa necessariamente ocupar um baud.

Uma transição do sinal transmitido pode levar mais de um bit, e essa possibilidade é atualmente usada tanto pelos sistemas de fax comuns como pelos modems mais rápidos dos computadores.

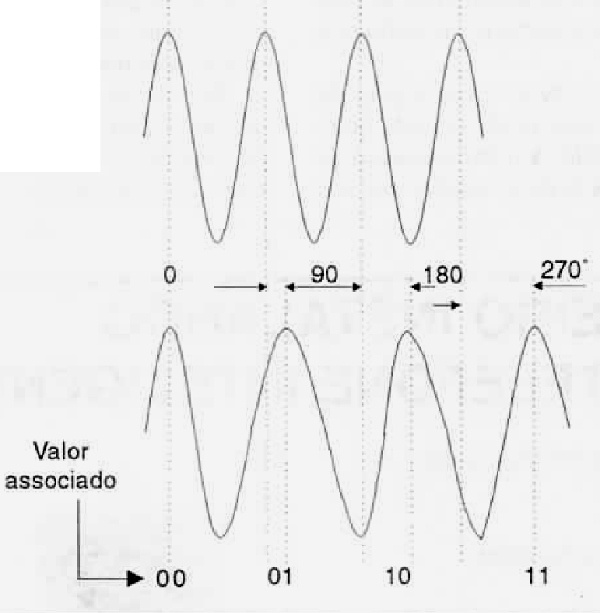

Uma primeira possibilidade consiste em usar a fase do sinal enviado pela linha para transmitir a informação: os pulsos não precisam chegar todos em sincronismo. Assim, podemos ter 4 tempos ou fases possíveis para cada ciclo do sinal transmitido ou baud, conforme ele esteja em fase, atrasado de 90 graus, 180 graus ou 270 graus em relação ao tempo de referência, conforme mostra a figura 13.

Esses retardos admitem, pois, quatro combinações de valores digitais que são 00, 01, 10 e 11. Podemos então transmitir 2 bits em lugar de um só por baud, se usarmos esta técnica de modulação.

Isso significa que mesmo tendo um limite de 3 000 Hz, um modem que opere com este sistema, pode trabalhar com 2 400 bauds e na verdade transmitir 4 800 bits por segundo!

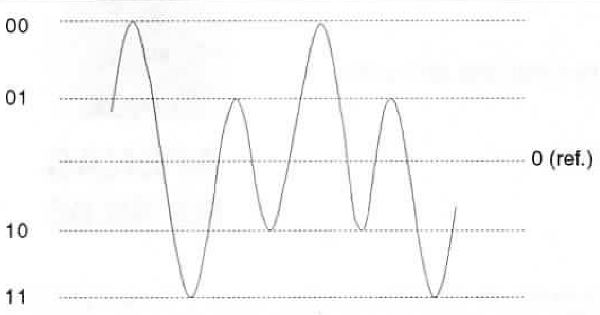

Essa velocidade pode ainda ser dobrada se em lugar de definirmos apenas dois níveis de intensidade para o sinal, como seria lógico num sistema digital, trabalharmos com 4 níveis.

Os sinais poderiam ter intensidades de 00. 01, 10 e 11, conforme mostra a figura 14.

Combinando a modulação em fase com a modulação em amplitude temos a transmissão de 4 bits por baud e a velocidade de nosso modem cresce para 9 600 bits por segundo, mesmo com uma operação real em 2 400 bauds.

A coisa vai além e hoje modems com 28 800 bits por segundo já são comuns nos PCs.

O mesmo recurso pode ser usado com a TV digital. Se usarmos os mesmos procedimentos de modulação, um canal que depois da compressão ocupe 20 MHz poderia ser reduzido a 5 MHz apenas e com isso até ser transmitidos pelos canais convencionais da TV em UHF e VHF (que então poderiam se tornar digitais facilmente).

QUALIDADE

Evidentemente, as técnicas de manuseio de dados de um receptor de TV digital não seriam as mesmas de um TV comum, o que levaria a circuitos muito mais complexos.

CARACTERISTICAS IMPORTANTES DA TV DIGITAL

A interferência causada por reflexões (fantasmas) pode ser totalmente eliminada assim como ruídos elétricos ou atmosféricos, pois o microprocessador do receptor, como nos modems comuns, pode conferir os bits que chegam eliminando os que não correspondem à transmissão.

Compatibilidade total como computadores, permitindo a futura integração dos receptores de TV com sistemas multimídia.

Possibilidade de agregar ao mesmo canal de imagem, informações digitalizadas entre quadros que correspondam a dados, sons, etc. É possível transmitir pelo menos 6 sinais de áudio simultâneos.

A regeneração de dados perdidos na transmissão permite obter uma qualidade de imagem acima do que seria possível em qualquer outro sistema.

Por outro lado, a qualidade de imagem seria sensacional além de recursos muito interessantes, como por exemplo a compatibilização total com os computadores.

As informações digitais que chegassem ao receptor poderiam ser diretamente gravadas ou trabalhadas nesta forma!

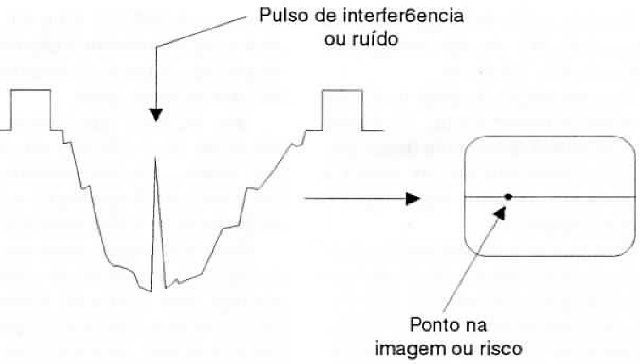

Imagina-se que uma imagem poderia ser gravada, e dotada de efeitos especiais como a possibilidade de ser deformada, girada ou vista de um outro ângulo, diferente do original! A qualidade seria garantida pelo processamento dos circuitos que facilmente poderiam detectar quando um bit “com defeito” chegasse ao receptor. Na TV comum, se um pulso de interferência ou ruído se sobrepõe ao sinal de vídeo, conforme sua intensidade, pode produzir efeitos visíveis na imagem e até a perda de sincronismo, conforme mostra a figura 15.

Como no caso dos CDs de música, um bit com “defeito" captado pelo circuito (um arranhão no disco, por exemplo) é reconhecido (por meio de um controle de paridade) e ignorado, não aparecendo na reprodução. Com a TV pode ocorrer o mesmo e de uma forma até mais complexa e perfeita. Um microprocessador pode detectar que o bit imperfeito afeta a produção de um ponto que faz parte de uma região vermelha da imagem (o anterior e o posterior são vermelhos). Neste caso, ele atribui ao bit “errado" valor que leve a cor vermelha. Em lugar de aparecer na imagem um ponto diferente que saltaria à vista ele simplesmente “se misturaria" naquele local e não seria percebido.

Se o bit estiver numa região de transição de cor, uma borda de objeto por exemplo, o microprocessador pode acusar isso e colocar no seu lugar um ponto intermediário que corresponda a uma “transição suave" entre as duas cores. a ponto de a vista não perceber.

Outra possibilidade de correção de problemas de interferências ou ruídos, seria ignorar o ponto que chegue com a informação defeituosa mantendo por um quadro o do quadro anterior. A nossa vista provavelmente não perceberia isso.

Em suma, será possível obter imagens com a qualidade dos CDs e da mesma forma como já é feito seu uso nos vídeo-laser.